MACHINE LEARNING IN DER ENERGIEBRANCHE

Entwicklung und Bewertung von Machine Learning-Modellen für die Prognose des Energieverbrauchs aus Schweizer Trafostationen

Falsche Stromprognosen und teure Kompensationszukäufe durch die Netz-gesellschaft Swissgrid aufgrund schneebedeckter Photovoltaikanlagen nach einem Wintereinbruch im April? Dieses kürzlich aufgetretene Ereignis in der Schweizer Energieversorgung unterstreicht die Bedeutung in diesem Forschungsbereich. Diese Bachelorarbeit hat verschiedene Machine Learning-Modelle entwickelt und hinsichtlich ihrer Eignung für die 48-Stunden-Prognose des Energieverbrauchs verglichen.

Kontext

Die zentrale Problemstellung der Studie ist die Nutzung von Echtzeitdaten aus Smart Metern im Energieversorgungssektor. Trotz grosser Datenmengen gibt es Herausforderungen bei der Nutzung dieser Daten in Echtzeit. Datenschutzbestimmungen und die Trägheit von IT-Systemen führen zu einer Datenlücke von bis zu zwei Tagen, was die präzise Einschätzung des aktuellen Energieverbrauchs erschwert. Die Studie wurde im Rahmen des Wirtschaftsinformatikbachelors an der Berner Fachhochschule durchgeführt, um die Eignung verschiedener Machine Learning-Modelle für die Vorhersage des Energieverbrauchs aus Schweizer Trafostationen zu untersuchen.

Ziel

Das Hauptziel dieser Bachelorarbeit bestand darin, Machine Learning-Modelle zu entwickeln und anhand definierter Kriterien zu evaluieren, um zeitnahe Prognosen zu Energieverbrauchsdaten zu erstellen. Durch diese Modelle soll die erwähnte Datenlücke überbrückt und die Echtzeitdatenverarbeitung verbessert werden. Dabei haben sich 7 Forschungslücken und die folgende Forschungsfrage herauskristallisiert:

Forschungsfrage

Welche Machine Learning-Modelle eignen sich am besten für die Prognose von Zeitreihendaten des Energieverbrauchs aus Schweizer Transformatorenstationen?

7 Forschungslücken:

- Integration und Analyse von Echtzeitdaten: Die Herausforderung bei der Integration von Echtzeitdaten aus Smart Metern und deren Nutzung für eine präzise Energieverbrauchsvorhersage sind noch nicht vollständig gelöst.

- Methodik: Die meisten Studien verwenden einen Ansatz und vergleichen diesen gegenüber einem anderen Modell oder untersuchen systematisch die Forschungsliteratur. Nur wenige Studien vergleichen die Leistung und die Effizienz der verschiedenen State-of-the-Art-Modelle im Vergleich für Zeitreihendaten umfassend.

- Vorhersagezeitraum: Die meisten Studien berücksichtigen die kurzfristige Energieverbrauchsprognose, jedoch nicht die langfristige Vorhersage.

- Bilanzierung von Energieflüssen: Die meisten Studien verwenden Energieverbrauchsdaten, berücksichtigen jedoch nicht die Energieproduktion durch Haushalte.

- Einflussfaktoren: Wenige Studien berücksichtigen zusätzlich zu den Daten meteorologische Einflüsse.

- Multidimensionale Evaluationskriterien: Die meisten Studien fokussieren sich auf die Vorhersagegenauigkeit. Nur wenige Studien berücksichtigen den Ressourcenaufwand sowie die Modellkomplexität.

- Reale Anwendungsszenarien: Keine gefundene Studie testet die Modelle mit Daten aus Transformatorenstationen in realen Anwendungsszenarien, um ihre praktische Tauglichkeit zu bewerten.

Methodik

In einem strukturierten Ansatz wurden Daten aus sieben Trafostationen über den Zeitraum Januar 2021 bis Dezember 2023 gesammelt und analysiert. Es folgte eine umfassende exploratorische Datenanalyse (EDA), um die relevanten Variablen zu identifizieren. Verschiedene Machine Learning-Modelle wurden auf ihre Vorhersagegenauigkeit hin untersucht. Angewendet wurden dabei traditionelle statistische Methoden (Lineare Regression, SARIMAX, Exponential Smoothing und TBATS) sowie fortschrittliche Deep Learning-Modelle (LSTM- und Transformer-Architektur). Die Evaluation der Modelle erfolgte anhand definierter Kriterien wie der Vorhersagegenauigkeit (gemessen am Mean Absolute Percentage Error), sowie der Komplexität und der Ressourceneffizienz der Modelle.

Angewendete Modelle

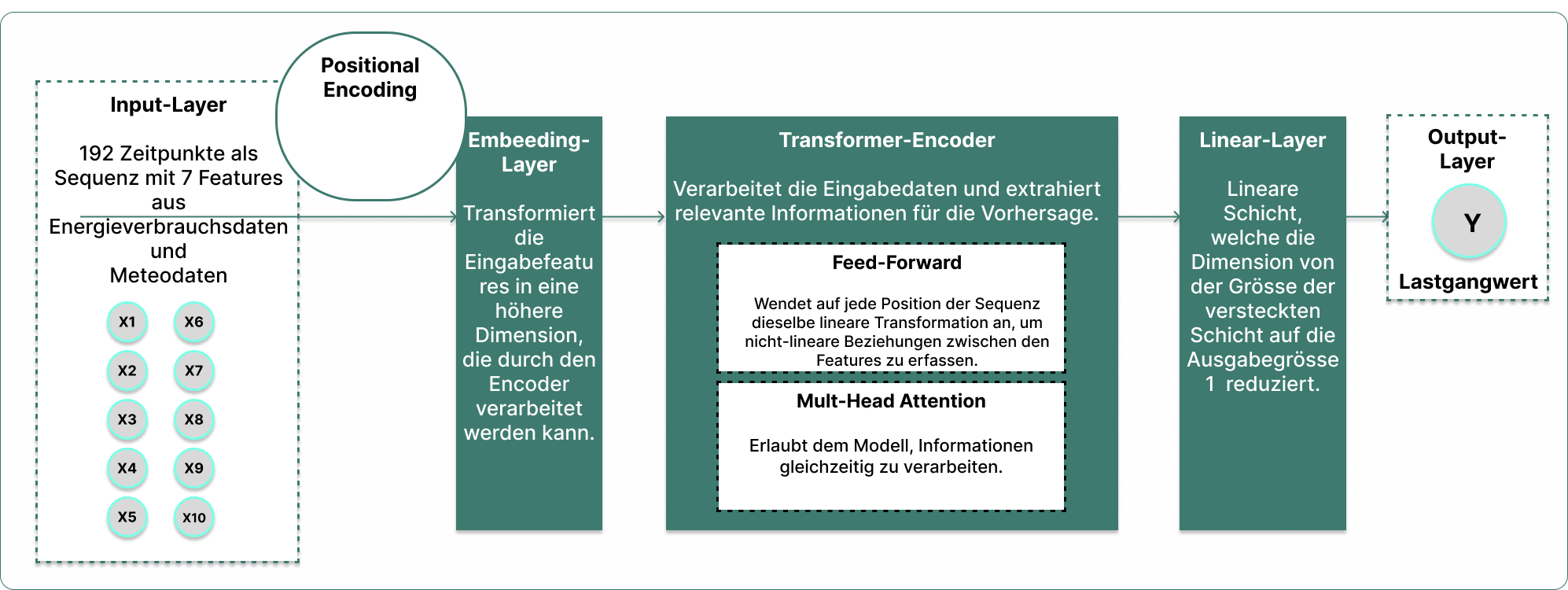

Zur Erstellung der Prognosen hat diese Arbeit neben der linearen Regression drei konventionelle statistische Modelle und zwei Deep Learning-Modelle verwendet. Die SARIMAX-Methode, aus der ARIMA-Familie, berücksichtigt Saisonalität und exogene Variablen. Exponential Smoothing gewichtet jüngere Beobachtungen stärker als ältere. TBATS ist für komplexe saisonale Muster entwickelt. LSTM-Architekturen können Informationen über viele Zeitschritte hinweg speichern, was sie ideal für Zeitreihenanalysen macht. Die Transformer-Architektur, eine Weiterentwicklung traditioneller sequenzbasierter Ansätze, verarbeitet Sequenzen in einem Schritt und erfasst Beziehungen durch Selbst-Attention. Das Bild zeigt eine Transformer-Architektur zur Verarbeitung von Zeitreihendaten:

Ergebnisse

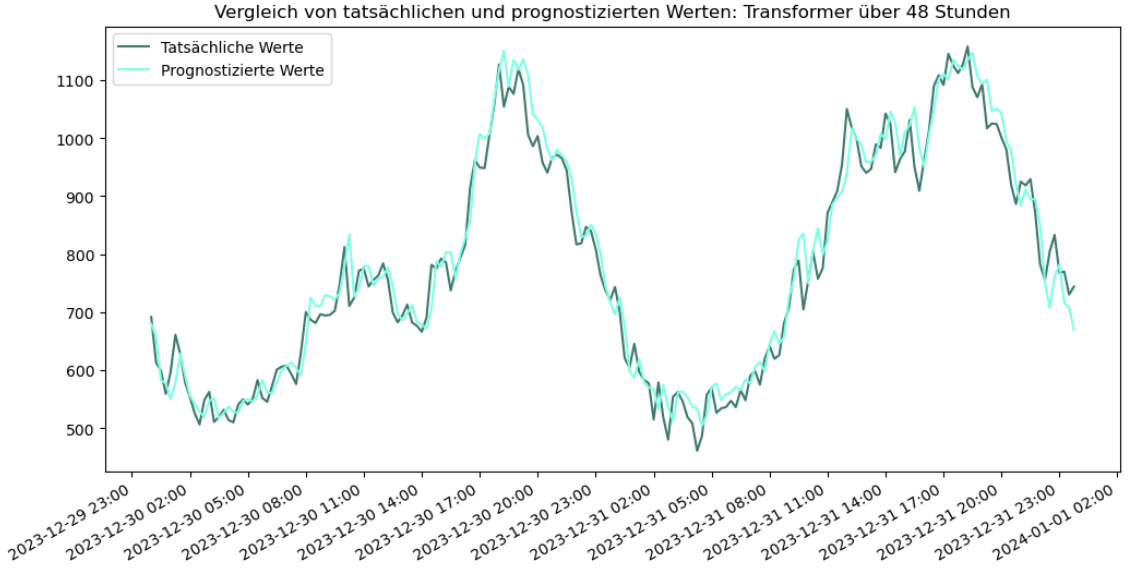

Die Ergebnisse zeigten, dass fortschrittliche Modelle wie LSTM und Transformer, beide mit einem MAPE unter 4 % zu präziseren Vorhersagen führen als die untersuchten konventionellen statistischen Methoden. Diese Modelle konnten die Datenlücken von 48 Stunden effektiv schliessen und eine genaue Prognose des Energieverbrauchs über kurze Zeitspannen ermöglichen. Überraschend war das Ergebnis, dass die Vorhersagegenauigkeit der Deep Learning-Modelle ohne die Einbeziehung meteorologischer Variablen nur minimal beeinträchtigt wurde. Dennoch sollten statistische Modelle nicht vollständig ausser Acht gelassen werden, insbesondere in Umgebungen, wo keine leistungsfähigen GPUs verfügbar sind, um komplexe Berechnungen effizient durchzuführen. Statistische Modelle wie das Exponential Smoothing haben durch geringen Ressourcenverbrauch bei gleichzeitiger guter Vorhersagegenauigkeit (MAPE von 10.74 %) überzeugt.

Die untenstehende Abbildung zeigt die vorhergesagten Werte über 48 Stunden mit einer Transformer-Architektur im Vergleich zu den tatsächlichen Werten.

Ausblick

Diese Arbeit zeigt trotz vielversprechender Ergebnisse der verwendeten Modelle mehrere Bereiche auf, die weitere Untersuchungen benötigen. Zukünftige Forschungen sollten die folgenden noch offenen Fragen adressieren:

- Weitere Untersuchungen sind nötig, um den Einfluss von Meteodaten auf die kurzfristige Vorhersagegenauigkeit des Energieverbrauchs zu klären. Erste Ergebnisse zeigen nur eine geringe Verschlechterung des MAPE ohne Meteodaten, was auf einen geringeren Einfluss hindeutet als angenommen. Das oben erwähnte Beispiel, bei dem schneebedeckte Photovoltaikanlagen aufgrund eines unerwarteten Wintereinbruchs zu fehlerhaften Stromprognosen führten, widerspricht jedoch diesem Ergebnis und unterstreicht die Notwendigkeit weiterer Forschung in diesem Bereich.

- Eine genauere Prüfung der Einbeziehung von Energieproduktionsdaten durch Haushalte ist notwendig, insbesondere angesichts des Ausbaus von Photovoltaikanlagen.

- Weitere zeitbezogene Variablen könnten die Vorhersagegenauigkeit verbessern. Erste Tests mit der linearen Regression und zusätzlichen zeitbezogenen Variablen zeigen bereits eine messbare Verbesserung des MAPE-Wertes.

- Die Kombination von LSTM mit anderen Modellen wie CNNs sollte weiter erforscht werden, obwohl die LSTM-Architektur bereits gute Ergebnisse geliefert hat.

- Die Leistungsfähigkeit der Modelle bei längeren Vorhersagezeiträumen als 48 Stunden sollte überprüft werden.

- Die Integration der Modelle in reale Anwendungen sollte untersucht werden. Erste Tests zeigen, dass mindestens 3 Monate historische Daten für einen MAPE unter 10 % erforderlich sind.

Die gewonnenen Erkenntnisse dieser Arbeit bieten wertvolle Unterstützung für Energieversorgungsunternehmen, die durch den Einsatz von Machine Learning-Modellen ihre Datenlücken schliessen und genauere Energieverbrauchsprognosen erstellen möchten.